1、从能上网的电脑上下载3个文件 :

ollama安装文件: OllamaSetup.exe

chatbox安装文件: Chatbox-1.11.5-Setup.exe

2、将这3个文件复制到d:\ollama (我们是为了把所有程序都安装到此目录)

在D盘或其他盘内创建一个名为ollama的文件夹,将ollama安装包移动至该文件夹内

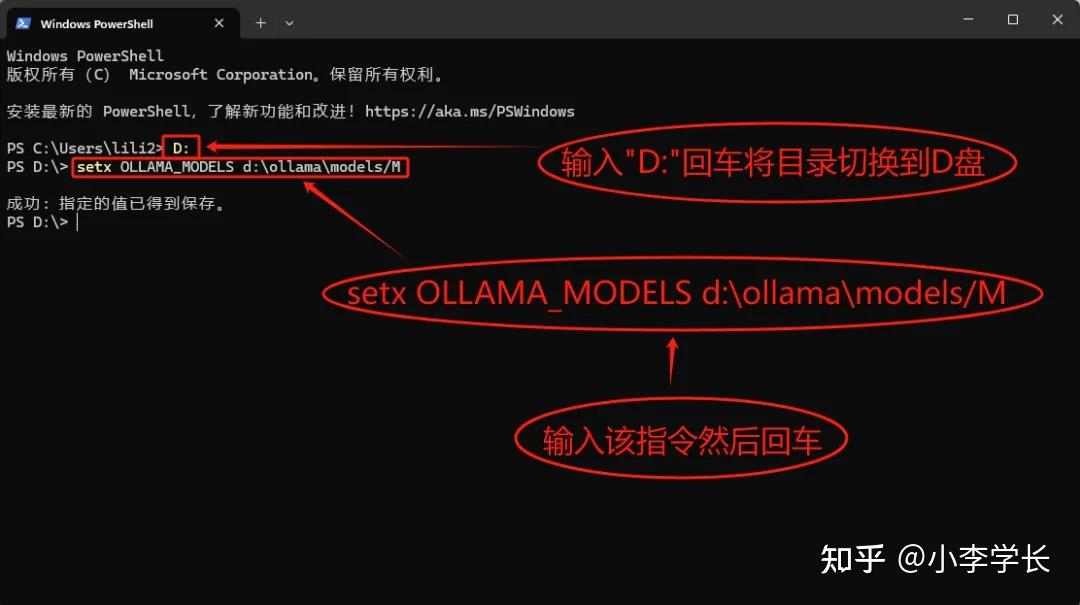

在cmd命令窗口输入“D:”将目录切换到D盘  2.jpg (51.27 KB, 下载次数: 0) 2.jpg (51.27 KB, 下载次数: 0)

下载附件 [url=]保存到相册[/url]

[color=rgb(153, 153, 153) !important]2025-4-5 09:27 上传

输入该指令: setx OLLAMA_MODELS d:\ollama\models/M 然后回车,提示“成功”就说明输入成功了 接下来继续 输入cd ollama 回车 再输入OllamaSetup.exe /dir=d:\ollama 回车 等待一会后,会自动弹出该界面,点击“Install/安装”进行安装 检测是否安装成功:在cmd令窗口输入:D: 回车

输入:cd ollama 回车 再输入ollama -v,如果像下面这样 显示“ollama version is 0.5.12” 就是安装成功了

3、设置环境变量

在D盘创建一个用于安装ollama模型的文件夹,文件夹名称设置成“ollamamx”(文件夹名称可以自定义)

创建一个“系统变量”, 变量名:OLLAMA_MODELS 变量值:在“浏览目录”找到我们刚才在D盘创建的“ollamamx”文件夹 下面我们再创建一个跟“系统变量”一样的“用户变量”

然后把ollama退出重新打开:桌面右下角找到“ollama” 鼠标右键点击选择“Quit ollama/退出ollama” 退出后再打开ollama 4、 下载大模型文件 如果部署的服务器无法直接连外网,可以先在能上网的一台笔记本上按照上述说明部署一个环境,然后在 cmd窗口输入: ollama run deepseek-r1:14b (可以从官网找到下载不同大型模的命令) 大模型文件开始下载 等下载完成后,将ollamamx 文件夹复制到部署的服务器上,替换服务器上的ollamamx文件夹。

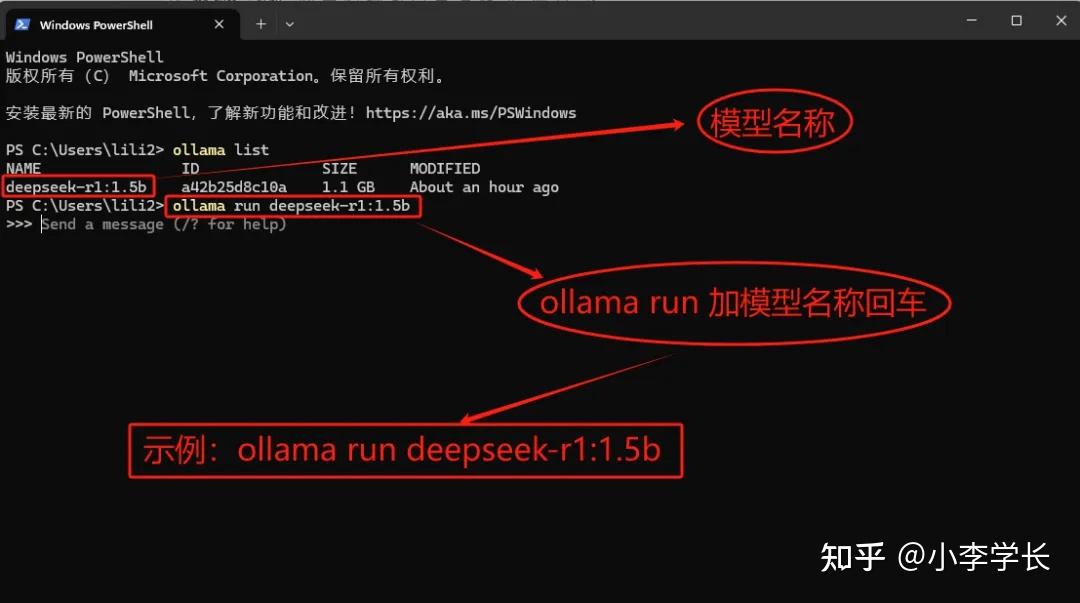

5、cmd窗口输入:ollama list 回车 查看已安装的模型 复制模型名称然后在指令窗口输入:ollama run 模型名称 回车即可进入对话

如何退出对话? A:指令窗口输入:/bye

6、部署chatbox 安装chatbox,点击左下角的设置 -模型提供方 选择: OLLAMAAPI 模型选择 deepseek-r1:14b---保存

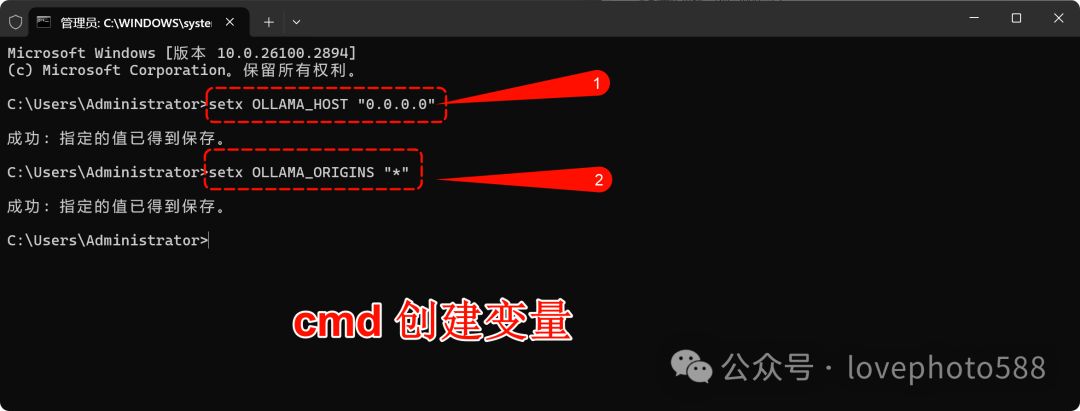

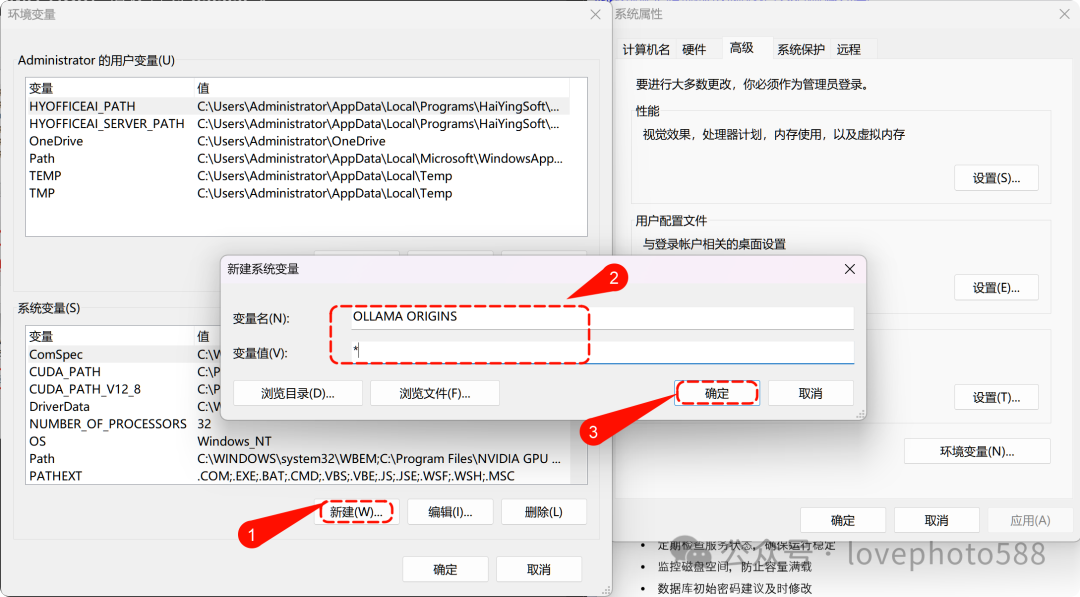

7、设置局域网访问:

默认Ollama仅允许本地访问,需创建Ollama变量,并设置系统环境变

使用管理员身份打开 cmd窗口 执行如下命令:

setx OLLAMA_HOST "0.0.0.0"

setx OLLAMA_ORIGINS "*"

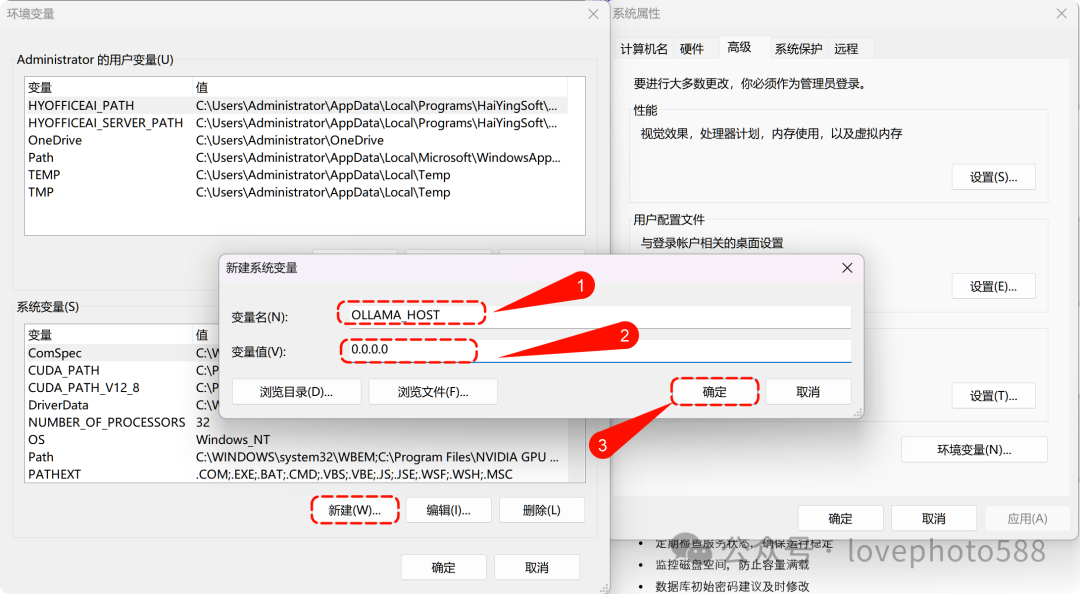

然后设置两个系统环境变量

系统变量OLLAMA_HOST 值设置为 0.0.0.0

系统变量OLLAMA ORIGINS 值设置为 * (备注 OLLAMA和 ORIGINS中间是空格,不是下划线)

电脑右下角右键退出 Ollama程序后,重新启动Ollama程序。

进入 chatbox 设置, api域名由 http://127.0.0.1:11434修改为 http://ip:11434

局域网中其他电脑上:

安装chatbox软件, 然后设置-模型提供方 选择: OLLAMAAPI API域名:http://ip:11434 模型选择 deepseek-r1:14b---保存

部署本地知识库

1、下载 AnythingLLM,https://anythingllm.com/desktop

2、在离线服务器上安装时,安装目录 d:\AnythingLLm,安装完之后会报错,提示需要联网下载一些依赖库。

3、找一台联网的机器,安装 anythingLLM,安装速度比较慢,而且最后也报错了,根据网上的建议,将dns修改为8.8.8.8,然后安装python,重新安装,安装正常。然后将D:\deepseek\AnythingLLM\resources\ollama\lib 目录复制覆盖到离线服务器上。

4、打开anythingllm-配置:

外观-displaylanguage 选择 chinese

LLM首选项: LLM提供商,选择 Ollama

向量数据库: 不变,默认的免费,其他有速度更快的,但是收费

Embedder首选项:嵌入引擎提供商: Ollama

保存

5、创建新工作区,工作区右侧点击设置

聊天设置:工作区LLM提供者 Ollama,聊天模式:查询,聊天提示:改为: 你是一个知识库专家,所有问题请用中文回答

6、向量数据库: 搜索偏好: Accuracy Optimized(准确性提升) ,最大上下文片段,改为10

7、代理配置: Ollama

8、本地知识库上传。

发现问题: AnythingLLM 只能单人使用,局域网中其他用户无法使用,除非其他人再安装AnythingLLM,但是其他人安装AnythinkLLM 又需要配置知识库,上传知识库。

9、所以需要安装 Docker AnythingLLM的方式,可以供局域网用户使用。

|  |官方商城|手机版|小黑屋|影子鹰社区

(

|官方商城|手机版|小黑屋|影子鹰社区

( ![]() 粤ICP备2021124288号 )

本站已运行天

粤ICP备2021124288号 )

本站已运行天